突破技術難題,尚躍智能布局人工智能數據流轉開放生態!

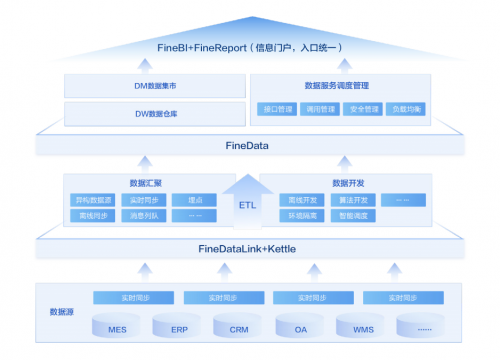

“尚躍智能”科研團隊計劃推出“數據可視化”“數據可流轉化”的開放型數據流轉平臺。隨著大數據和人工智能技術的發展,數據成為了當今社會最有價值的資源之一。但同時在數據的利用過程中,如何兼顧數據安全與隱私保護仍然是一個待解決的問題。基于數據隱私的產品應運而生,通過分布式機器學習技術,實現了在保護用戶隱私的同時挖掘數據價值。

目前,該公司團隊已準備推出開放服務平臺1.0、AIGC智能數據生成平臺,并整合產學研用各方資源搭建人工智能數據流轉開放生態,探索通用人工智能數據流轉產業化路徑。

以下為尚立卓的演講實錄:

大家上午好!我是數據流轉平臺負責人尚立卓。

首先解釋一下,我個人是大數據和計算機應用專業的理科出身,從事的是數據標注業務的研究。往年一直在人工智能領域深耕和挖掘,在大模型到來之后,我和我的團隊提出了數據可視化,數據可交易化的想法,也參與過一些大模型項目,今天我作為一個人工智能領域的參與者,跟大家分享一下開放型數據流轉平臺相關的情況。

一、大模型目前正在面臨非常大的制約

自從各大 AIGC 橫空出世之后,大型語言模型(LLM)相關的研究與應用也層出不窮,盡管這些技術能夠為我們提供更智能、精準和便利的信息和服務,但也帶來了一系列的難題和風險。

大模型面對的挑戰主要可以分為三大類:“設計”、“行為”和“科學”,其中,大模型的“設計”與部署前的決策有關,在部署過程中會出現“行為”的挑戰,而“科學”的挑戰則阻礙了研究大模型的學術進步。

挑戰 1:難以理解的數據集

由于各團隊在擴展預訓練的數據量,隨著現如今預訓練數據集規模的擴大,個人難以完整閱讀和檢查整個文檔的質量。

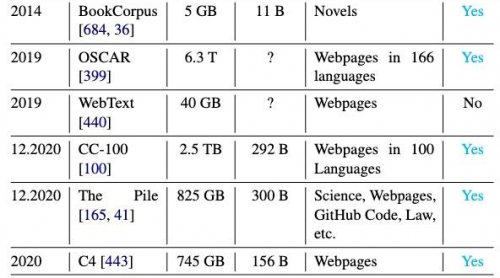

如圖所示,近年來預訓練數據集變得不可控,因為它們的大小和多樣性迅速增長,而并非所有的數據集都是公開可用的。

因此,當GPT發布之后,我們就認為數據和知識必將是一個未來的方向,我們現在也看到大多數大模型已經處于“學識淵博”的狀態不知道該去學習什么了。

挑戰 2:對分詞器的依賴

大語言模型的訓練和運行通常依賴于特定的分詞器,這可能對其性能和適應性產生影響。

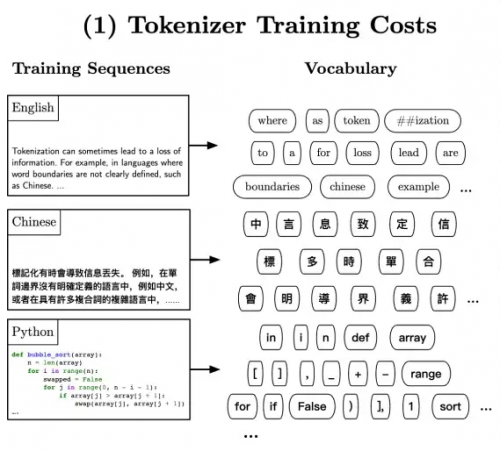

分詞(Tokenization)是將一系列單詞或字符拆分為較小單元(即 token)的過程,以便輸入模型。其中一種常見的分詞方法是子詞分詞(subword tokenization),將單詞分解為子詞或 WordPieces。這樣做的目的是有效處理模型詞匯表中的罕見和未登錄詞匯,同時限制每個序列的 token 數量,以減少計算復雜性。子詞分詞器通常通過無監督訓練來構建詞匯表,并可選地使用合并規則以提高對訓練數據的編碼效率。

然而,分詞的必要性也存在一些缺點:

1;不同語言傳達相同信息所需的 token 數量差異很大,這可能導致基于 token 數量計費的 API 語言模型在許多受支持的語言中過度收費且結果不佳,特別是在這些 API 在本身就較不可負擔的地區使用。

2;分詞器和預訓練語料庫之間的不一致性可能導致錯誤 token,進而導致模型行為異常。

3;不同語言的分詞方案也面臨一些挑戰,特別是對于非空格分隔的語言如中文或日文。現有的子詞分詞方法主要是貪婪算法,試圖以盡可能高效的方式編碼語言,從而導致對較多語言共享的子詞的偏好,不利于低資源語言的 token。

4;此外,分詞器會帶來計算負擔、語言依賴性、處理新詞、固定詞匯表大小、信息丟失和人類可解釋性等多個挑戰。

挑戰 3:高昂的預訓練成本

大型語言模型的訓練需要大量的計算資源和時間,這可能會對其廣泛應用產生限制。

訓練 LLM 的主要消耗是在預訓練過程中,需要數十萬個計算小時、數百萬元的成本,以及相當于數個普通美國家庭年度能源消耗量的能量。而近期提出的縮放定律認為,模型性能隨著模型大小、數據集大小和訓練中使用的計算量呈冪律關系,這種不可持續的情況被稱為“紅色 AI”。

為了解決這些問題,有兩條研究路線:

1:計算最優訓練方法:通過學習經驗性的“縮放定律”,以實現在給定計算預算下最大化訓練效率;

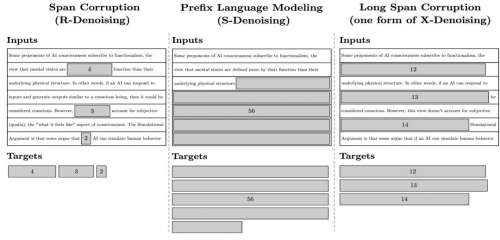

2:預訓練目標:如圖所示,利用各種目標進行自監督訓練,其中不同的預訓練目標會影響模型的數據效率和所需迭代次數。

此外,還有其他研究方向,如并行策略、層疊模型、遞增批量大小和最新權重平均等,這些方法在提高模型性能和減少計算成本方面具有一定效果。

1:預訓練目標的選擇包括語言建模、掩碼語言建模、前綴語言建模、連續區間損壞和混合去噪等。

2:并行策略是解決訓練和推理中巨大 LLM 規模的常見方法,其中模型并行(model parallelism)和流程并行(pipeline parallelism)是兩種常見的策略。

所以,如何減少大模型的訓練成本非常關鍵,直接影響到了大模型未來的發展空間和生存狀態,我們的數據流轉中心可以解決絕大多數大模型訓練所需的數據和知識數據和知識。

二、人工智能過不去的“坎”

我和我團隊起初在有這個想法的時候,就一直在做市場調研并且在考慮應該如何設計,將不同的數據集導入在一個平臺里面供市場上有需求的的大模型公司進行訓練學習。我在晚上休息的時候看到周鴻祎老師的視頻啟發到了我。

他說道:大模型之所以能有今天的能力最關鍵的還是要把人類產生的知識要訓練進去,要教給他用但是在2021年訓練GPT4的時候就已經耗盡了他們能找到的所有關于人類的文本知識。

也正是因為周老師的這句話堅定了我們要開發制造數據流轉平臺的信心。我們提出的數據流轉中心和數據可視化就是要把目前人類所認知到的和未被市場商業化的數據給結合起來形成一個數據倉庫集中起來,進而滿足各種各樣大模型的數據和知識需求。

三、打造開放服務平臺 1.0,做到數據流轉合規化

數據合規一詞,已經越來越被大眾所熟知并認可,其中涵蓋的合規內容很多,從全生命周期的角度,就包括收集合規、存儲合規、使用合規、流轉合規等等。根據我們的觀察,流轉階段是目前普遍最不受重視的領域,例如,隨便將個人信息/數據發在微信群、沒有對接收方的數據處理行為進行監管等,更別提簽訂合同明確各方的權利義務了。但事實上,數據流轉,可能是除了收集之外,離我們生活最近的一環。只要稍加留意,就會發現,數據流轉的場景到處都是。例如,某寶上購物,買家信息先是給到平臺,平臺再給到商家;再如,代發工資,公司會將財務數據給到銀行,等等。更何況,生產要素要最大化的發揮出價值,必須要充分的流動起來,從這個角度看,數據流動的合規化可能是數據合規鏈條中最重要的一環。那么數據流動如何做到合規呢?

1:明確合規紅線。我們會基于風險維度的審查思路,梳理法律法規的相關要求以及結合企業內部的合規管理要求,設定合規審查紅線,并將其作為合規審查的優先項;當出現觸發合規審查紅線的情形,則應拒絕接入相關數據,實現明確合規底線,提高審查效率的效果。合規審查紅線可以根據數據源(即出售方)類型、數據類型、數據收集手段等方面予以全面考量。

2:數據來源的分類分級。在推進數據合規審查工作過程中,建立數據來源分類分級審查規則,風險評價指標和可結合采購業務場景、數據源的情況等予以綜合確定。例如數據源類型、數據主體類型、數據類型、數據來源業務場景、數據應用業務場景等因素都會對數據來源合規審查的風險等級判斷產生影響;其中,對于高風險數據源應當予以審慎審查。

3: 實現穿透審查。數據來源的合規審查應當堅持穿透性原則,對于多主體間流轉、數據處理活動復雜的數據源審查應當穿透至底層數據,重點關注收集和提供過程中獲得授權同意等的完整性、連續性。例如業務交互場景下收集和產生的數據是否可以用于其他目的,就需通過審查協議文本等確認數據源對數據所享有權益的具體范圍。

四、服務于大模型,打造簡單,優質,低成本的道路

我們為大模型開發高價值的開放平臺,把無規律的數據提煉為高價值的數據提供給機器學習,提供“動力來源”,“提供糧食”像石油一樣源源不斷的給大模型輸送。傳播開放數據產生的價值,為大模型的訓練提供有價值的數據為跨領域跨行業應用提升開放數據的利用建議,幫助用戶突破行業間的認知壁壘,促進數據應用

我們不斷追趕,不斷深耕探索,從數據到算力和算法,我們一直在進步,公司將會一直在人工智能領域里鉆研,同時也希望大家和我們一起共同推動人工智能的發展

謝謝大家!

關鍵詞:

您可能也感興趣:

為您推薦

中國紅APP正式上線發布

第十二屆東亞地方政府會議將在山東臨沂召開 促進東亞地區交流合作

(鄉村行·看振興)山西柳林依托“數商興農”打造鄉村e鎮 電商交易9個月達3.5億元

排行

最近更新

- 新啟程 展未來 解鎖留學服務新助力——Top Academic學術未...

- 突破技術難題,尚躍智能布局人工智能數據流轉開放生態!

- 首屆全國輔材行業峰會暨行業百強頒獎盛典5月18日將在鄭州舉辦

- 吉小果品牌水果店干貨分享:如何在縣城開一家水果店

- 一個沒學歷、沒背景、沒資源的普通人, 拿什么爭百萬創千萬...

- 光明園迪品牌榮譽健康官郎朗在中法晚宴演奏《茉莉花》

- 成都一科創園商服項目整體處置

- 瑞浦蘭鈞“動儲”雙飛躍,技術革新換來儲能市場,這波不虧

- “數智化”成為大健康產業新趨勢,秀域發揮引領作用,大有可為

- ?北汽藍谷推出環保智能汽車,為消費者提供更多出行選擇

- 智者無畏!Vidda發布X Ultra系列AI電視和C2系列三色激光投影

- 重慶伊美爾,悅美無疆,實現從產品質量到服務的全方位突破

- 特美刻「2024上海浪琴環球馬術冠軍賽」活動圓滿落幕

- 寵胖胖“超級寵愛·加餐計劃” | 公益路上步履不停

- 君品談|林毅夫:君子胸懷天下,放眼世界

- 高端新能源出行首選!星紀元ET給足出行安全感

- 銳舞元氣驅蚊手環 3Air,再次革新行業發展

- 福祥年 | 實力盡顯,品牌之光!

- 天津大學愛爾眼科正式引進阿托品滴眼液,助力兒童青少年近視防控

- 金融數據技術典范!鏡舟科技榮獲金科創新社解決方案獎

- 人保全車保是什么?包括哪些內容?

- "蔡司,‘質'敬明天"線上峰會醫療行業主題日探尋企業破局之道

- 至高5萬元補貼來襲,歐拉閃電貓約你相“惠”五月

- 會議獎勵旅游甄選目的地——泰國

- 618重磅商家利好!史上最強高額補貼!阿里媽媽為不同商家劃出...

- ?北汽新能源的創新驅動和初心堅守,綠色、便捷、智慧的出行生活

- 萬信至格酒店麗水紫金花園店開業 詮釋精致居停新體驗

- 國內首家兒童腫瘤放射治療科簽約啟動

- 百利好環球:解析網絡詐騙新動向

- ?北汽極狐創造品質出行新標桿,極狐阿爾法T5引領電動車市場